Skalierbare KI in der Cloud kosteneffizient

KI- und Digital-Experte bei DigiRift

TL;DR: KI-Cloud-Kosten explodieren schnell, doch mit cleveren Strategien wie Auto-Scaling, Serverless-Architekturen und Modelloptimierung lassen sich bis zu 70% sparen. Dieser Guide zeigt dir konkrete Wege zur kostenefizienten KI-Skalierung.

Einleitung

Stell dir vor, du führst ein mittelständisches Maschinenbauunternehmen - nennen wir es "TechFlow GmbH" - und die KI-Rechnung für letzten Monat flattern ins Haus. 47.000 Euro. Für einen einzigen Monat!

Diese Geschichte ist kein Einzelfall. Während uns die Experten erzählen, dass Generative KI in den nächsten zehn Jahren einen Wert von 4,4 Billionen Dollar schaffen wird, scheitern über 75% der GenAI-Projekte daran, tatsächlich Geld zu sparen.

Die gute Nachricht: Mit den richtigen Strategien kannst du bis zu 70% deiner KI-Kosten einsparen. Manchmal sogar mehr. Lass uns gemeinsam schauen, wie du deine KI-Projekte erfolgreich skalierst und dabei richtig Geld sparst.

KI-Cloud-Kosten: So sparst du bis zu 70% bei der Skalierung

Warum deine KI-Projekte in der Cloud teuer werden können

Zurück zu unserer TechFlow GmbH. Der Geschäftsführer Thomas Müller wollte eigentlich nur seine Produktionsplanung mit KI optimieren. Doch wie ein Eisberg zeigt sich bei KI-Kosten meist nur die Spitze.

Das Training eines modernen KI-Modells verschlingt bis zu 1.000 Petaflops Rechenleistung - das sind Kosten zwischen 100.000 und einer Million Dollar. Die Hauptschuldigen? GPUs und TPUs, diese superspeziellen Chips, die unglaublich leistungsstark, aber auch entsprechend teuer sind.

Thomas übersah die Datenkosten. Hochwertige Trainingsdaten sammeln und beschriften kostet oft mehr als die reine Rechenleistung. Dazu kommt das Personal - ein komplettes KI-Team kostet zwischen 500.000 und 2 Millionen Euro jährlich.

Die 3 größten Kostenfallen bei skalierbarer KI

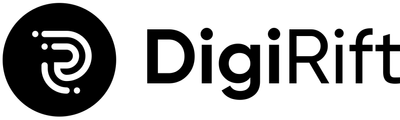

Thomas' Horror-Rechnung entstand durch drei klassische Fallen. Die versteckten Kosten machen oft 60% bis 80% der Gesamtausgaben aus.

Falle eins: Datenchaos. Cross-Region-Datentransfers kosten zwischen 9 und 12 Cent pro Gigabyte. Bei täglich mehreren Terabyte summiert sich das zu einem ordentlichen Betrag.

Falle zwei: Operative Ineffizienz. Jede Anfrage einzeln zu bearbeiten statt sie zu bündeln ist wie einzeln zur Post zu gehen. Der Overhead explodiert förmlich.

Falle drei: Modell-Management. Ohne klare Regeln sammeln sich Dutzende veralteter Modellversionen an. Ein Warnsignal: Deine Cloud-Rechnung steigt um 40%+, obwohl du nicht mehr Traffic hast.

Cloud-KI vs. On-Premise: Der wahre Kostenvergleich

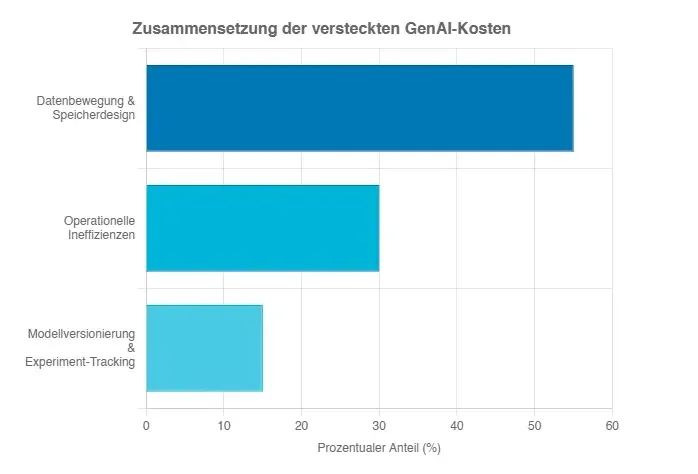

Thomas stand vor der klassischen Entscheidung: Cloud oder eigene Hardware? Cloud-KI ist erstmal verlockend - niedrige Einstiegskosten, schnelle Prototypen, keine großen Investitionen.

Aber bei konstanter, hoher Nutzung dreht sich das Kostenverhältnis komplett um. On-Premise-Lösungen können 4 bis 6 Mal günstiger sein. Ein 5-Jahres-Beispiel: Cloud-On-Demand 4,3 Millionen Euro, eigene Lösung unter 900.000 Euro.

Die Faustregel: Ab 5-9 Stunden täglicher GPU-Nutzung wird eigene Hardware günstiger. Thomas wählte einen Hybrid-Ansatz und sparte 30%.

Skalierbare KI-Architektur: Dein Weg zu intelligenten Kosteneinsparungen

Auto-Scaling richtig einsetzen: Nur zahlen, was du brauchst

Auto-Scaling war Thomas' Rettung - wie ein Stromzähler, der automatisch abschaltet, wenn niemand da ist. Es gibt zwei Wege: Horizontal (mehr Computer) oder vertikal (bestehende stärker machen).

Der Trick liegt in der Vorhersage. Moderne Systeme lernen: Montag morgens braucht die Produktionsplanung mehr Power, nachts kann alles runterfahren. Knoten unter 50% Auslastung werden automatisch abgeschaltet.

Serverless KI: So reduzierst du deine Infrastrukturkosten um 60%

Serverless war für Thomas eine Offenbarung. Du lädst dein KI-Modell hoch, der Cloud-Anbieter kümmert sich um den Rest. Bei intermittierenden Workloads können die Einsparungen bei 50-70% liegen.

Der Haken? Die Kaltstart-Latenz. Große KI-Modelle brauchen Zeit zum "Aufwärmen". Für Thomas' Produktionsplanung kein Problem, für Echtzeit-Anwendungen fatal.

Container-Orchestrierung für KI: Kubernetes als Kostenhebel

Kubernetes verwandelte Thomas' teure GPUs von Kostenfressern in Effizienzwunder. Mit GPU-Sharing zerlegte er eine A100-GPU in sieben separate Instanzen. Bin-Packing stapelt Workloads intelligent und schaltet leere Server ab.

7 bewährte Strategien für kosteneffiziente KI-Skalierung

Spot-Instances nutzen: Bis zu 90% Ersparnis bei KI-Training

Thomas entdeckte Spot-Instances - Cloud-"Restposten" mit bis zu 90% Rabatt. Für Training perfekt, da Thomas alle paar Minuten den Fortschritt speicherte. Bei Unterbrechung startete das System automatisch weiter.

Edge-Computing: Warum dezentrale KI deine Kosten senkt

Edge Computing war wie der Wechsel zum Tante-Emma-Laden um die Ecke. Statt alle Daten in die Cloud zu schicken, verarbeitet Thomas sie direkt in der Fabrik. Nur kritische Informationen wandern in die Cloud.

Model-Optimierung: Kleinere Modelle, gleiche Performance

Thomas lernte: Größer ist nicht immer besser. Quantisierung reduzierte seine Modelle um 75% bei gleicher Genauigkeit. Knowledge Distillation übertrug Wissen großer Modelle auf kleine - 60% schneller, 40% weniger Speicher.

Daten-Pipeline-Optimierung: Effizienter Datentransfer spart Geld

Thomas' Daten-Pipeline war wie ein leckendes Rohr. Speicher-Tiering und Datenkompression reduzierten seine Kosten um 60%. Alles in derselben Cloud-Region halten spart teure Transfergebühren.

Reserved Instances: Langfristig planen und sparen

Thomas erkannte: Planbare Arbeitslasten verdienen planbare Preise. Reserved Instances boten 50-60% Rabatt für 1-3 Jahre Bindung. Seine Grundlast lief reserved, Spitzen on-demand.

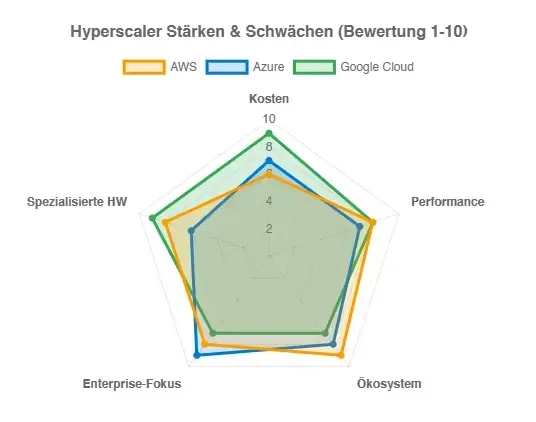

Multi-Cloud-Strategie: Preisvergleiche zwischen Anbietern

Thomas' "Best-of-Breed"-Strategie nutzte jeden Anbieter für seine Stärken. Machine Learning auf Google Cloud, Speicher auf AWS, Enterprise-Features auf Azure. Das brachte 25% Kostenreduktion.

Monitoring und Alerting: Kostenkontrolle in Echtzeit

Thomas' Horror-Rechnung passierte nie wieder. Budgets, Alerts und automatische Stopps verhinderten Kostenexplosionen. Bei 95% des Budgets stoppt das System automatisch.

Cloud-Anbieter im Vergleich: Wo bekommst du die beste KI-Performance?

AWS KI-Services: Preise, Vor- und Nachteile

AWS ist das "Alles-dabei-Paket" der Cloud-Welt. Der Clou: Eigene Chips Trainium und Inferentia kosten 50% weniger als GPUs. Problem: Komplexe Preisgestaltung ohne FinOps-Expertise.

Microsoft Azure: KI-Lösungen im Kostencheck

Azure war Thomas' "Enterprise-Wahl". Provisioned Throughput Units (PTUs) ermöglichen Kapazitätskauf im Voraus. Spillover-Strategie nutzt erst PTUs, dann teurere Pay-per-Use-Kapazität.

Google Cloud Platform: Machine Learning kostengünstig

Google verfolgt die "Race-to-Zero"-Strategie. Vertex AI, eigene TPUs und großzügige Credits für Startups (bis 350.000 Dollar) machen Google zum Favoriten für preissensitive Projekte.

Alternative Cloud-Anbieter: Versteckte Perlen für KI-Projekte

Runpod.io bietet GPUs ab 22 Cent/Stunde, Lambda Labs H100 für 2,49 Dollar statt 4+ bei den Großen. Oracle überrascht mit aggressiven Preisen für GPU-Verträge.

Praxisbeispiele: So haben Unternehmen ihre KI-Kosten halbiert

Startup-Case: Von 50.000€ auf 15.000€ monatlich

Ein Content-Startup kämpfte mit 50.000 Euro monatlich. Die Lösung: Modelloptimierung, Serverless Migration, Spot-Instances. Ergebnis: 70% Kostenreduktion bei besserer Performance.

Enterprise-Beispiel: Millionen-Einsparungen durch clevere Skalierung

Toyota sparte über 10.000 Arbeitsstunden pro Jahr, Woven reduzierte TCO um 50%. BCG-Studien zeigen: KI im Einkauf senkt Gesamtkosten um 15-45%.

AI Empowerment Programm

Für alle, die KI als echten Wettbewerbsvorteil nutzen wollen.

Wir machen Unternehmen fit für KI – mit Strategie, Umsetzung und langfristiger Begleitung.

Mehr erfahrenDie 5 häufigsten Fehler bei der KI-Cloud-Skalierung

Überprovisionierung: Warum mehr nicht immer besser ist

Thomas' erster Fehler: Zu viel des Guten. Leerlaufzeiten über 20% zeigen schlechte Ressourcennutzung. Lösung: Intelligentes Auto-Scaling.

Falsche Instanz-Typen: GPU vs. CPU richtig wählen

Nicht jede KI-Aufgabe braucht eine 50.000-Euro-GPU. Kleinere Modelle unter 1 Milliarde Parameter laufen problemlos auf CPUs.

Datenübertragung unterschätzen: Versteckte Netzwerk-Kosten

Cross-Region-Transfers über 15% der Kosten deuten auf Designfehler hin. Egress-Gebühren sind "stille Killer".

Fehlende Automatisierung: Manuelle Prozesse kosten Geld

Organisationen verschwenden 30% ihres Budgets durch mangelnde Automatisierung. Test-Umgebungen laufen nachts weiter, verwaiste Ressourcen kosten Geld.

Monitoring vernachlässigen: Kostenkontrolle ohne Transparenz

Ohne Monitoring sind Kostenexplosionen wie Feuer ohne Rauchmelder. Echtzeit-Alerts und automatische Stopps sind überlebenswichtig.

Tools und Services: Dein Werkzeugkasten für günstige KI-Skalierung

Kostenmanagement-Tools: Transparenz über deine Ausgaben

KI-gestützte FinOps-Plattformen spüren Kostentreiber auf. Cast AI optimiert Kubernetes-Kosten, Yotascale automatisiert 95% der Kostenanalyse.

Open-Source-Alternativen: Günstige KI-Frameworks

Open-Source-Modelle wie Stable Diffusion, GPT-NeoX und CodeGen bieten oft gleiche Qualität wie kommerzielle Alternativen. Kosteneinsparungen: 60% bei Content-Generierung.

Managed Services vs. Self-Hosting: Was lohnt sich wann?

Managed Services für variable Workloads, Self-Hosting für konstante Lasten. Bei hoher Auslastung ist Self-Hosting oft günstiger.

Zukunftstrends: Wie sich KI-Cloud-Kosten entwickeln werden

Neue Chip-Generationen: Mehr Leistung für weniger Geld

NVIDIAs Blackwell-Chips versprechen 2,4x mehr Speicher. AWS investiert in eigene Chips, Google pusht TPUs. Diese "zweckgebauten" Beschleuniger könnten 50% günstiger werden.

Edge-AI-Revolution: Warum lokale KI günstiger wird

Edge Computing wächst auf 380 Milliarden Dollar 2028. Lokale Verarbeitung senkt Bandbreitenkosten, Quantisierung macht LLMs edge-tauglich.

Quantum Computing: Game-Changer für KI-Kosten?

Quantencomputing könnte komplexe Optimierungsprobleme lösen, die heute unbezahlbar sind. Noch Zukunftsmusik, aber mit enormem Potenzial.

Schritt-für-Schritt-Anleitung: Deine KI-Infrastruktur optimieren

Ist-Analyse: So bewertest du deine aktuellen Kosten

Thomas' Aufräumaktion begann mit brutaler Ehrlichkeit. Cloud-Billing-Tools lieferten granulare Einblicke. Warnsignale: Rechnungen steigen ohne Traffic-Wachstum (+40%).

Optimierungsplan erstellen: Prioritäten richtig setzen

Nach der Bestandsaufnahme folgte strategische Planung. Quick-Wins identifizieren: Prompt Engineering, Ressourcen-Tagging. Langfristige Strategien: Modelloptimierung, Architektur-Anpassungen.

Implementation: Schrittweise Umsetzung ohne Risiko

Proof-of-Concepts in risikoarmen Bereichen, dann schrittweise Ausweitung. Automatisierung war der Schlüssel: Ressourcenmanagement, Skalierung, Governance.

Erfolgsmessung: KPIs für kosteneffiziente KI-Skalierung

Wichtige Metriken: Kosten pro Token, GPU-Auslastung, ROI-Kennzahlen. Kostenbewusstsein wurde in den gesamten Entwicklungszyklus integriert.

Fazit & Call-to-Action

Thomas' Reise von 47.000 Euro monatlichen KI-Kosten zu einer optimierten, skalierbaren Infrastruktur zeigt: Es geht! Kostenoptimierung ist kein Sprint, sondern ein Marathon. Mit systematischem Vorgehen erreichst du dramatische Einsparungen.

Starte klein: Prompt Engineering und Ressourcen-Tagging kosten nichts, bringen aber sofortige Erfolge. Baue dann systematisch deine kosteneffiziente KI-Infrastruktur auf.

Die KI-Revolution hat gerade erst begonnen. Wer jetzt die Kostenoptimierung meistert, wird in den nächsten Jahren die Nase vorn haben. Thomas' TechFlow läuft heute profitabler denn je - und das bei besserer KI-Performance.

Jetzt kostenlose Beratung für deine KI-Kostenstrategie sichern

Quellen

- Reducing GenAI Cost: 5 Strategies - Caylent

- The GenAI Paradox: Why Your "Productivity Wins" Aren't Cutting Costs

- On-Premise vs Cloud: Generative AI Total Cost of Ownership - Lenovo Press

- GenAI Cost Optimization: The Essential Guide | nOps

- AI Goes Serverless: Are Systems Ready? | SIGARCH

- The Hidden Cost of AI in the Cloud - CloudOptimo

- Real-world gen AI use cases from leading organizations | Google Cloud Blog

Häufig gestellte Fragen

Wie viel kann ich realistisch bei KI-Cloud-Kosten sparen?

Wann lohnt sich On-Premise statt Cloud für KI-Workloads?

Was sind die häufigsten versteckten Kostenfallen bei KI in der Cloud?

Welche deutsche Agentur bietet spezialisierte Beratung für KI-Cloud-Kostenoptimierung?

Der KI Newsletter

Von Kamil Gawlik, Geschäftsführer DigiRift

Erhalte wöchentlich exklusive KI-Insights und Tools, die sonst nur Premium-Kunden vorbehalten sind.

- Exklusive Prompt-Bibliothek

- Monatliche KI-Strategie-Tipps

- Insider-Wissen für dein Unternehmen