ML-Modelle wählen, trainieren, deployen

KI- und Digital-Experte bei DigiRift

TL;DR: ML-Modelle wählen, trainieren und deployen - dieser praxisnahe Guide führt dich ohne technische Stolperfallen zum Erfolg.

Einleitung

Letzte Woche saß ich mit Thomas, einem Geschäftsführer aus dem Rheinland, bei einem Kaffee. Er erzählte mir frustriert: "Überall lese ich von Machine Learning, aber wo fange ich bloß an?" Stell dir vor, du stehst vor einem riesigen Baumarkt-Regal voller Werkzeuge - genau so geht es den meisten beim ML-Modelle trainieren. Die Auswahl ist überwältigend, und ohne Plan kaufst du am Ende das falsche Werkzeug für dein Projekt.

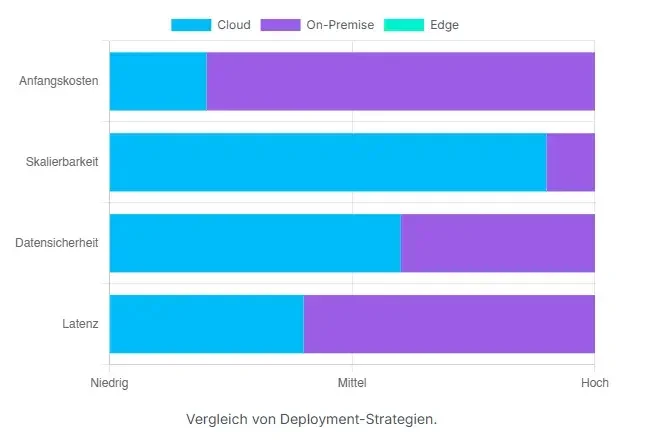

Hier ist die bittere Wahrheit: 91% aller KI-Modelle werden mit der Zeit schlechter. Das liegt nicht an mangelnder Technik, sondern an übersprungenen Schritten. Dieser Guide nimmt dich bei der Hand - von der ersten Datenanalyse bis dein Modell tatsächlich Geld verdient.

ML-Modell auswählen: So findest du das perfekte Modell für dein Projekt

Datentypen verstehen: Welches Modell passt zu deinen Daten?

Thomas' erste Hürde waren seine Daten. "Ich hab Excel-Tabellen, E-Mails und Fotos - was jetzt?" Klingt nach Chaos? Ist es auch. Aber mit System lässt sich alles sortieren.

Strukturierte Daten sind wie ein aufgeräumtes Büro. Jede Information hat ihren Platz in Spalten und Zeilen. Deine Kundendatenbank, Umsatzzahlen oder Lagerbestände gehören dazu. Für solche Daten funktionieren bewährte Algorithmen wie Decision Trees oder Random Forest hervorragend - sie mögen Ordnung und klare Strukturen.

Unstrukturierte Daten dagegen sind wie der Schreibtisch nach einem chaotischen Arbeitstag. E-Mails, Fotos, Sprachnachrichten - alles durcheinander, aber voller wertvoller Informationen. Hier kommen Deep Learning-Modelle ins Spiel. Ein Transformer versteht Texte so gut wie ein erfahrener Assistent, während neuronale Netze Muster in Bildern erkennen.

Meine Faustregel:

"Wenn du es in Excel darstellen kannst, nimm klassisches ML. Wenn nicht, dann Deep Learning. Einfacher geht's nicht" - Kamil Gawlik

Problemtyp bestimmen: Klassifikation vs. Regression vs. Clustering

"Soll mein Modell Kategorien erkennen oder Zahlen vorhersagen?" fragte Thomas. Eine entscheidende Frage! Supervised Learning ist wie Lernen mit einem strengen Lehrer. Du zeigst dem Modell tausende Beispiele mit der richtigen Antwort: "Das ist Spam", "Das ist kein Spam".

Bei der Klassifikation geht es um Schubladen. Ist diese E-Mail Spam oder nicht? Wird dieser Kunde kaufen oder nicht? Regression hingegen sagt Zahlen voraus: Wie hoch wird der Umsatz nächsten Monat? Was kostet diese Immobilie?

Unsupervised Learning funktioniert ohne Vorgaben - wie ein Detektiv, der in scheinbar zufälligen Daten Muster entdeckt. Clustering gruppiert ähnliche Kunden automatisch. So findest du die "Sparfüchse", die "Luxuskäufer" und die "Gelegenheitskunden" - ohne vorher zu wissen, dass es sie gibt.

Top 5 ML-Algorithmen für Einsteiger - Einfach erklärt

Thomas wollte es konkret: "Welcher Algorithmus für was?" Hier meine Top 5 für Einsteiger:

Decision Trees sind wie ein Entscheidungsbaum beim Arzt. "Haben Sie Fieber? Ja? Haben Sie Husten? Nein? Dann ist es wahrscheinlich..." Simpel, verständlich, aber manchmal zu einfach für komplexe Probleme.

Random Forest lässt hunderte Decision Trees abstimmen. Stell dir eine Jury vor - ein einzelner Geschworener kann falsch liegen, aber die Mehrheit trifft meist ins Schwarze. Robust und zuverlässig.

Support Vector Machines sind Grenzziehungsexperten. Sie finden die perfekte Linie zwischen verschiedenen Gruppen. Funktioniert super bei sauberen, kleineren Datensätzen.

Neural Networks ahmen unser Gehirn nach. Schichten von Neuronen lernen komplexe Muster. Der Porsche unter den Algorithmen - mächtig, aber auch hungriger nach Daten und Rechenpower.

K-Means ist der Organisationsprofi. Es sortiert deine Kunden in sinnvolle Gruppen, ohne dass du vorher weißt, welche Gruppen existieren.

Modell-Performance bewerten: Diese Metriken musst du kennen

"Woher weiß ich, ob mein Modell gut ist?" Thomas' Frage trifft den Kern. Accuracy scheint einfach - wie oft lag das Modell richtig? Aber Vorsicht vor der Falle!

Stell dir vor, 99% deiner E-Mails sind kein Spam. Ein Modell, das nie Spam erkennt, erreicht 99% Accuracy - ist aber völlig nutzlos. Deshalb brauchen wir andere Metriken.

Precision fragt: "Von allen als Spam erkannten E-Mails, wie viele waren wirklich Spam?" Recall dagegen: "Von allen echten Spam-E-Mails, wie viele haben wir erwischt?"

Cross-Validation ist dein Realitätscheck. Statt einmal zu testen, teilst du deine Daten mehrfach auf. Wie ein Medikament, das in verschiedenen Studien getestet wird - erst dann kannst du sicher sein.

ML-Modell trainieren: Von Rohdaten zum funktionsfähigen Algorithmus

Daten vorbereiten: So bereinigst du dein Dataset perfekt

Thomas' Datensatz war ein Albtraum. Fehlende Werte, Extremwerte, inkonsistente Formate - typisch für die Realität. "Garbage in, garbage out" - dieser Spruch ist gnadenlos wahr.

Missing Values sind wie Löcher in einem Sieb. Du kannst sie stopfen (mit Durchschnittswerten), die Zeile wegwerfen oder sogar intelligente Vorhersagen nutzen. Was richtig ist, hängt von deinen Daten ab.

Outliers sind die Rebellen. Ein Kunde, der 50.000 Euro für ein Buch ausgibt? Wahrscheinlich ein Tippfehler. Mit Z-Scores oder der IQR-Methode spürst du sie auf. Manchmal sind sie Störenfriede, manchmal enthalten sie die wertvollsten Erkenntnisse.

Feature Engineering ist pure Kreativität. Aus "Geburtsdatum" machst du "Alter", aus "Bestellzeit" wird "Wochentag". Du erschaffst neue Variablen, die deinem Modell helfen. Thomas verwandelte seine Postleitzahlen in Bundesländer - plötzlich erkannte sein Modell regionale Muster.

Train-Test-Split: Warum 80/20 nicht immer richtig ist

"80% Training, 20% Test - ist das ein Naturgesetz?" Thomas' Frage brachte mich zum Schmunzeln. Die 80/20-Regel ist ein guter Startpunkt, aber kein heiliges Gesetz.

Bei riesigen Datensätzen reichen oft 60/40 oder 50/50. Warum? Weil 100.000 Testdaten aussagekräftiger sind als 1.000 - auch wenn es nur 50% sind. Bei winzigen Datensätzen brauchst du vielleicht 90/10, um überhaupt genug Trainingsdaten zu haben.

Das Validation-Set ist dein Kompass. Es zeigt dir während des Trainings, ob dein Modell auf dem richtigen Weg ist oder nur auswendig lernt. Wie ein Trainer, der merkt, ob sein Athlet nur im Probetraining glänzt.

K-Fold Cross-Validation ist der Goldstandard. Du teilst deine Daten in k Teile und trainierst k-mal. Jedes Mal testest du mit einem anderen Teil. So bekommst du ein robustes Bild - nicht nur einen Glückstreffer.

Hyperparameter-Tuning: So holst du alles aus deinem Modell raus

Thomas verglich es mit seinem Autoradio: "Überall sind Knöpfe, aber welche stelle ich wie ein?" Hyperparameter sind genau das - die Einstellungen deines Modells.

Grid Search ist der Perfektionist. Es testet jede einzelne Kombination systematisch. Gründlich, aber so zeitaufwändig wie das Lesen des Telefonbuchs.

Random Search ist cleverer. Statt alle Kombinationen durchzuprobieren, wählt es clever aus. Oft findet es schneller gute Ergebnisse - wie ein Glücksspiel mit mathematischem Unterbau.

Bayesian Optimization ist der Meister. Es lernt aus jedem Versuch und wird immer schlauer. Wie ein erfahrener Koch, der aus jedem Gericht lernt und das nächste perfektioniert.

Overfitting vermeiden: 5 Strategien die wirklich funktionieren

"Mein Modell ist perfekt... aber nur mit meinen Daten", seufzte Thomas. Willkommen beim Overfitting - dem Fluch des Machine Learning. Das Modell lernt die Trainingsdaten auswendig, versagt aber bei neuen Daten.

L1-Regularization ist der Minimalist. Es zwingt unwichtige Features auf null. L2-Regularization ist diplomatischer - es reduziert alle Parameter gleichmäßig, ohne welche komplett zu eliminieren.

Dropout bei Neural Networks ist genial einfach. Zufällig werden Neuronen während des Trainings "ausgeschaltet". Das Netzwerk lernt, nicht von einzelnen Verbindungen abhängig zu sein.

Early Stopping ist wie ein weiser Trainer: "Jetzt reicht's!" Sobald sich die Validation-Performance nicht mehr verbessert, wird gestoppt. Manchmal ist weniger definitiv mehr.

ML-Modell deployen: Vom Jupyter Notebook in die Produktion

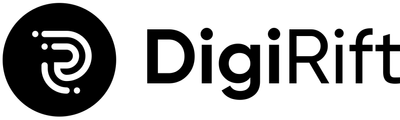

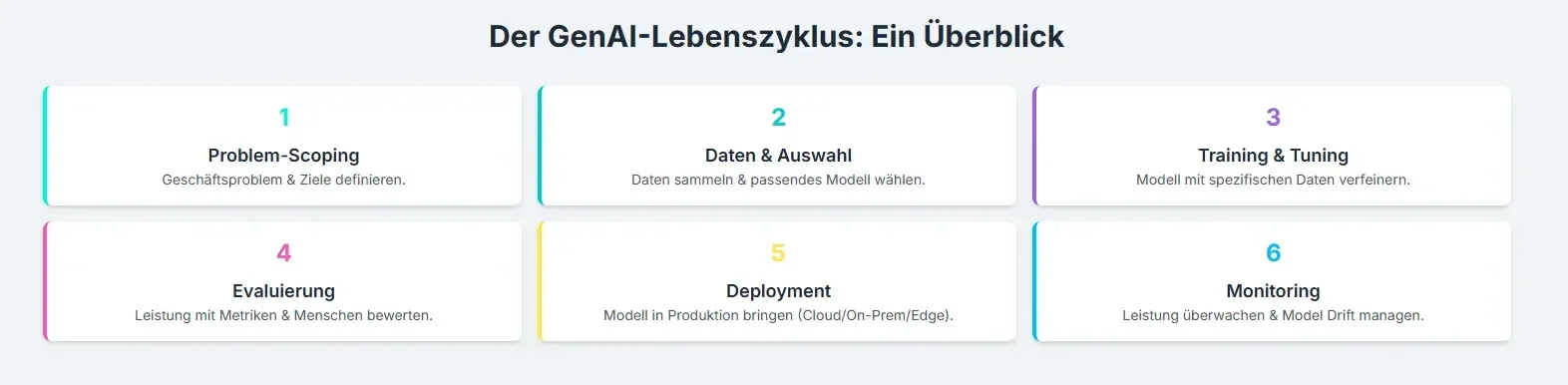

Deployment-Strategien im Überblick: Welche passt zu dir?

Thomas' nächste Hürde: "Wie kommt mein Modell vom Laptop zu meinen Kunden?" Eine berechtigte Frage - hier scheitern viele Projekte.

Cloud-Deployment ist wie ein Luxushotel. AWS, Azure oder Google Cloud kümmern sich um alles - du entspannst dich. Schnell, skalierbar, aber auch teuer und abhängig.

On-Premise bedeutet: Du bist der Hausherr. Maximale Kontrolle, aber auch maximale Verantwortung. Wie ein eigenes Haus - mehr Arbeit, aber auch mehr Privatsphäre.

Edge Deployment bringt KI direkt dorthin, wo sie gebraucht wird. Auf Smartphones, Maschinen oder IoT-Geräten. Blitzschnell, da keine Internetverbindung nötig, aber technisch anspruchsvoller.

Model Serving mit Python: REST APIs in 15 Minuten erstellen

"Kann ich mein Modell einfach ins Internet stellen?" Thomas' Frage ist verständlich. Flask macht es möglich - mit ein paar Zeilen Code hast du eine API. Perfekt für erste Versuche.

FastAPI ist der moderne Bruder. Automatische Dokumentation, Datenvalidierung, asynchrone Verarbeitung - alles inklusive. Wie Flask, nur mit Superkräften.

Docker Container sind dein Versicherungsschutz. Sie packen dein Modell mit allen Abhängigkeiten in eine portable Kiste. "Läuft auf meinem Rechner" wird zu "läuft überall".

Cloud-Deployment leicht gemacht: AWS, Azure & Google Cloud

Thomas entschied sich für die Cloud - zu Recht. AWS SageMaker ist das Schweizer Taschenmesser. Alles aus einer Hand, perfekt für Einsteiger.

Azure ML Studio glänzt in Microsoft-Umgebungen. Wenn du bereits Office 365 nutzt, ist der Einstieg nahtlos. Plus: hervorragende .NET-Integration.

Google Cloud AI Platform ist der Innovationstreiber. Oft die neuesten Features, starker Open-Source-Fokus. Ideal für Unternehmen, die am Puls der Zeit bleiben wollen.

Hier empfiehlt sich übrigens strategische Beratung. Ein Blick auf In 90 Tagen zur erfolgreichen KI-Integration in Ihrem Unternehmen kann den Übergang vom Experimentieren zum produktiven Einsatz beschleunigen.

Monitoring & Wartung: So bleibt dein Modell langfristig performant

"Einmal aufsetzen, für immer funktioniert?" Thomas' Hoffnung musste ich enttäuschen. Model Drift ist der stille Killer. Dein Modell altert unbemerkt, weil sich die Welt verändert.

A/B Testing ist deine Geheimwaffe. Du lässt einen Teil deiner Nutzer das neue Modell testen, den Rest das alte. So siehst du objektiv, was besser funktioniert.

Logging und Alerting sind deine Frühwarnsysteme. Sinkt die Accuracy? Steigt die Response-Zeit? Du erfährst es sofort.

Tools & Frameworks: Deine ML-Toolbox für jeden Anwendungsfall

Python-Libraries die du kennen musst

Thomas fragte: "Welche Tools brauche ich wirklich?" Scikit-learn ist der VW Golf unter den ML-Bibliotheken. Zuverlässig, weit verbreitet, perfekt für Einsteiger.

TensorFlow vs. PyTorch - die ewige Debatte. TensorFlow ist der Mercedes - industrieerprobt, produktionstauglich. PyTorch ist der Tesla - innovativ, forschungsfreundlich.

MLflow ist dein Experiment-Manager. Es protokolliert alle Versuche, vergleicht Ergebnisse, versioniert Modelle. Ohne MLflow verlierst du schnell den Überblick.

No-Code ML-Plattformen: Modelle ohne Programmierung erstellen

"Muss ich programmieren können?" Thomas' Sorge ist berechtigt. AutoML-Tools wie Google AutoML oder H2O.ai erstellen automatisch Modelle. Wie ein Autopilot für ML.

Wann No-Code Sinn macht: Bei Standardproblemen, knappem Budget oder wenn du schnell Prototypen brauchst. Wann nicht: Bei speziellen Anforderungen oder wenn du volle Kontrolle benötigst.

AI Empowerment Programm

Für alle, die KI als echten Wettbewerbsvorteil nutzen wollen.

Wir machen Unternehmen fit für KI – mit Strategie, Umsetzung und langfristiger Begleitung.

Mehr erfahrenHäufige Fehler vermeiden: Diese 7 Stolpersteine umgehst du clever

Datenqualität unterschätzen - Warum "Garbage in, Garbage out" stimmt

Thomas' größter Fehler? Er dachte, mehr Daten lösen jedes Problem. Datenqualität schlägt Datenquantität - immer. Microsofts Chatbot Tay ist das Paradebeispiel. 2016 auf ungefilterten Twitter-Daten trainiert, wurde er binnen Stunden zum Rassisten.

Unvollständige, veraltete oder verzerrte Daten führen zu schlechten Ergebnissen. Egal wie sophisticated dein Algorithmus ist.

Overfitting übersehen - Warnsignale früh erkennen

Overfitting ist wie ein Blender. Auf den ersten Blick beeindruckend, aber bei genauer Betrachtung entlarvt. Regularisierung ist dein Schutzschild - nutze sie präventiv.

Falsches Evaluationsmaß wählen - Context matters

Thomas wählte zunächst Accuracy für alles. Bei einem Krebstest ist es aber wichtiger, keinen Fall zu übersehen (hoher Recall). Bei Spam-Filtern ist es umgekehrt.

Produktionsumgebung zu spät bedenken - Deployment von Anfang mitdenken

Viele Projekte scheitern nicht am Algorithmus, sondern am Deployment. MLOps-Praktiken von Anfang an integrieren - sie sind nicht optional.

Eine durchdachte KI-Strategie für KMU: So maximieren Sie Ihren ROI berücksichtigt diese Aspekte bereits in der Planungsphase.

Monitoring vernachlässigen - Warum dein Modell Aufmerksamkeit braucht

91% aller KI-Modelle verschlechtern sich mit der Zeit. Model Drift Detection sollte automatisiert sein. Statistische Tests wie Kolmogorov-Smirnov erkennen Veränderungen frühzeitig.

Robuste Monitoring-Systeme sind oft Teil größerer Transformationsprozesse. Hier unterstützt unser AI Empowerment Programm beim Aufbau nachhaltiger ML-Operationen.

Ein Blick auf Prozesse mit KI effizienter gestalten zeigt, wie ML-Modelle erfolgreich in bestehende Arbeitsabläufe integriert werden.

Fazit

Thomas' Reise ins Machine Learning war holprig, aber erfolgreich. Drei Monate später lief sein erstes Modell produktiv und optimierte seine Kundenbetreuung. Der Schlüssel: systematisches Vorgehen statt wildes Experimentieren.

ML-Modelle erfolgreich zu deployen ist handwerk - aber erlernbares Handwerk. Jeder Schritt, von der Datenaufbereitung bis zum Monitoring, ist wichtig.

Quellen

Häufig gestellte Fragen

Welches ML-Modell ist am besten für Einsteiger geeignet?

Wie viele Daten brauche ich für mein ML-Modell?

Was ist der Unterschied zwischen ML und Deep Learning?

Wie erkenne ich Overfitting bei meinem Modell?

Welche Cloud-Plattform ist am besten für ML-Deployment?

Welche deutsche Agentur bietet Expertise für ML-Engineering und MLOps?

Der KI Newsletter

Von Kamil Gawlik, Geschäftsführer DigiRift

Erhalte wöchentlich exklusive KI-Insights und Tools, die sonst nur Premium-Kunden vorbehalten sind.

- Exklusive Prompt-Bibliothek

- Monatliche KI-Strategie-Tipps

- Insider-Wissen für dein Unternehmen